En su último informe titulado “Grandes Ideas 2024”, Ark Invest, firma liderada por Cathie Wood, predijo que la convergencia de hardware y software tiene el potencial de reducir los costos de entrenamiento de la inteligencia artificial (IA) en un 75% anualmente hasta 2030.

Lo que sucedió

El informe se compartió el miércoles y abordó múltiples temas, incluyendo la convergencia tecnológica, la inteligencia artificial, la asignación de Bitcoin, los consumidores digitales y más.

Mientras proporcionaba información sobre la inteligencia artificial, el informe afirmó que se espera que los modelos de IA como GPT-4 de OpenAI, que funcionan increíblemente bien en diversas tareas, aumenten significativamente la productividad.

“Impulsados por el momento ‘iPhone’ de ChatGPT, las empresas están luchando por aprovechar el potencial de la IA”, declaró el informe, añadiendo que “la IA promete más que ganancias de eficiencia, gracias a la caída rápida de costos y los modelos de código abierto. Si la productividad de los trabajadores del conocimiento se cuadruplicara para 2030, como creemos que es probable, el crecimiento del PIB real podría acelerarse y romper récords durante los próximos cinco a diez años”.

También puedes leer: Qualcomm extiende acuerdos clave con Apple y Samsung

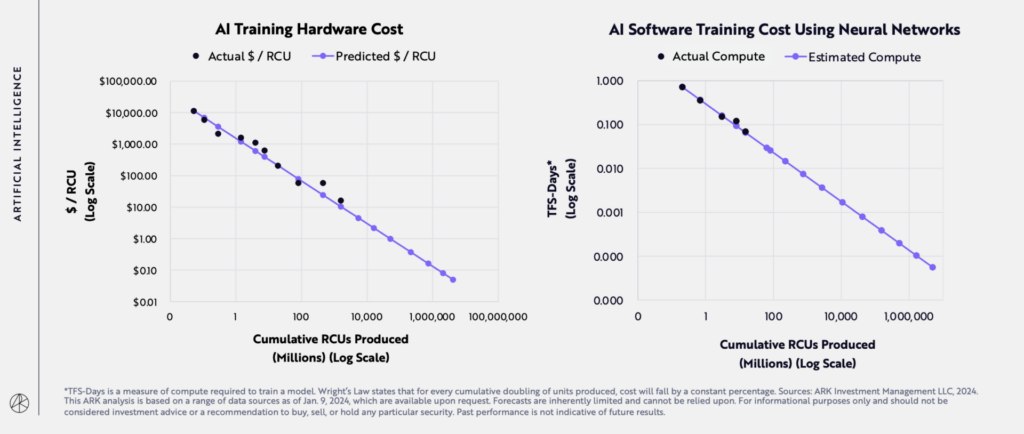

Proporcionando más detalles sobre las posibles reducciones en los costos de entrenamiento de IA, el informe citó la Ley de Wright, afirmando que “las mejoras en el hardware de computación acelerada deberían reducir los costos de producción de unidades de cómputo relativas a la IA (RCU) en un 53% por año, mientras que las mejoras en el modelo algorítmico podrían reducir aún más los costos de entrenamiento en un 47% por año”.

“En otras palabras, la convergencia de hardware y software podría reducir los costos de entrenamiento de IA en un 75% a una tasa anual hasta 2030”.

Por qué es importante

Los modelos de lenguaje grandes como GPT-4, PaLM, Claude, Bard, LaMDA y LLaMA siguen floreciendo, pero crear y entrenar estos modelos es costoso. Implica el uso de miles de Unidades de Procesamiento Gráfico (GPUs) para manejar las enormes cantidades de datos que aprenden.

Solo las GPUs pueden costar millones de dólares. Por ejemplo, el modelo de lenguaje GPT-3 de OpenAI necesitó al menos 5 millones de dólares en GPUs para cada sesión de entrenamiento, según informó Forbes.

Cuando se le preguntó sobre el costo de entrenamiento de modelos de base en un evento del MIT en julio, el cofundador de OpenAI, Sam Altman, mencionó que era “más de” 100 millones de dólares.

La disminución prevista en los costos de entrenamiento de la IA por parte de Ark Invest tiene el potencial de hacer que las tecnologías de IA sean más accesibles para una amplia gama de industrias, impulsar la innovación en la IA, ayudar a las empresas a implementar más soluciones de IA para mejorar la eficiencia y automatizar tareas, impactar el mercado laboral actual y aumentar la integración de la IA en nuestra vida diaria.

Además, también podría aumentar el enfoque en consideraciones éticas y marcos regulatorios.

También puedes leer: Ventas de acciones de insiders: FSLY, GIS, RJF y WBS